L’américain Ambiq, concepteur de microcontrôleurs, puces-systèmes et horloges temps réel à ultrabasse consommation destinés au marché de l’IoT, estime avoir accomplr une percée technologique dans le domaine des aides auditives en mettant en œuvre une technologie d'amélioration de la parole et des images alimentée par des algorithmes d’intelligence artificielle (IA) intégrés nativement au sein de son microcontrôleur Apollo510, introduits sur le marché en mars 2024.

Les aides auditives appliquent notamment des modèles d’IA sophistiqués d’Ambiq pour améliorer l’expérience d’écoute de l’utilisateur en utilisant des réseaux neuronaux d’apprentissage profond en vue de supprimer le bruit de fond et mieux identifier les environnements acoustiques. Le détecteur de scène acoustique est à ce niveau jugé particulièrement puissant par la sociét car il ajuste les légères nuances du signal qui dépassent souvent la capacité de l’oreille humaine à les distinguer dans des environnements acoustiques bruyants.

Les capacités de calcul économes en énergie sur les architectures matérielles d’Ambiq, ont rendu la mise en œuvre de de ces fonctionnalités d’IA possibles, représentant selon la socité une nouvelle étape dans la sophistication de l’IA pour les prothèses auditive avec en sus une autonomie prolongée de la batterie pour une utilisation ininterrompue tout au long de la journée

D’un point de vue technologique, ces systèmes d’aide auditive s’appuient sur des modèles d’apprentissage profonds fondés sur des réseaux de neurones. A savoir, le NNSD (Neural Network Speech De-Noiser), un modèle d’apprentissage profond en temps réel qui analyse l’audio pour isoler la parole et supprimer les bruits de fond gênants afin d’améliorer l’expérience utilisateur, le NNAED (Neural Network Acoustic Environment Detection), un modèle d’IA d’apprentissage profond très sensible qui identifie les files d’attente acoustiques subtiles pour ajuster le traitement audio en fonction de l’environnement de l’utilisateur de manière dynamique ou encore l’AAASP (Advanced Adaptive Audio Software Processing) mécanisme qui exploite l’IA pour proposer une expérience audio claire et nette, avec en sus la possibilité de personnaliser les sources sonores, ajustées en fonction des habitudes et des préférences de l’utilisateur.

Ces approches fondées sur l’IA ont pour socle d’une part l’architecture des microcontrôleurs Apollo510, à cœur Arm Cortex-M55 (adapté selon Arm à l’exécution de tâches d’intelligence artificielle) à ultra base consommation (inférieure à 3 µA/MHz) et d’autre part sur la bibliothèque neuralSPOT AI d'Ambiq. Pour rappel, NeuralSPOT AI, est un kit de développement logiciel de fonctionnalités d’IA disponible en open source associée à une boîte à outils pensée pour les plates-formes matérielles d’Ambiq. Ce SDK (Software Development Kit) comprend des bibliothèques pour communiquer avec les capteurs, gérer les blocs périphériques des puces-systèmes de la société, contrôler les configurations d'alimentation et de mémoire… ainsi que des outils pour déboguer les modèles IA.

« En réduisant radicalement les besoins en énergie du traitement audio très complexe et des fonctionnalités d’IA requises par les prothèses auditives avancées, nous estimons pouvoir éliminer le besoin en ASIC spécialisés et coûteux, accélérant ainsi les cycles de production des prothèse auditives », précise Carlos Morales, vice-président de l’IA chez Ambiq.

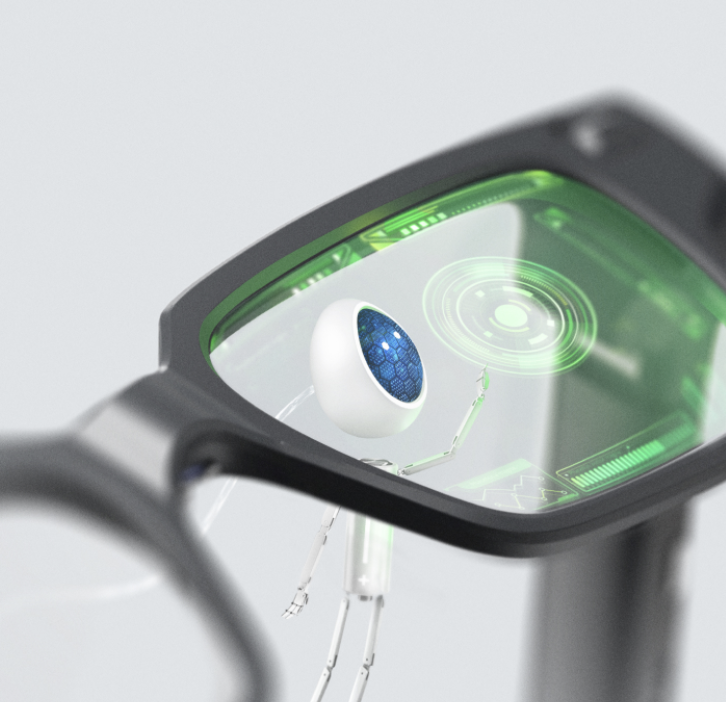

Parallèlement, Ambiq s’est récemment associé à son compatriote ThinkAR, un pionnier dans les technologies de réalité augmentée et d'IA, afin de développer des lunettes intelligentes légères appelées AiLens. Les AiLens fournissent un assistant personnel alimenté par des algorithmes d’IA qui aide à gérer la traduction linguistique en temps réel, des notes et rappels, des informations de santé, etc. Ces lunettes fonctionnent avec la puce-système Apollo4 d’Ambiq fondée sur cœurs Arm Cortex-M4F fonctionnant jusqu’à 192 MHz pour les traitement des graphiques, de l’audio et des modèles d’IA. Ces lunettes qui ne pèsent que 37 grammes, procure jusqu’à 10 heures d’autonomie.

Parallèlement, Ambiq s’est récemment associé à son compatriote ThinkAR, un pionnier dans les technologies de réalité augmentée et d'IA, afin de développer des lunettes intelligentes légères appelées AiLens. Les AiLens fournissent un assistant personnel alimenté par des algorithmes d’IA qui aide à gérer la traduction linguistique en temps réel, des notes et rappels, des informations de santé, etc. Ces lunettes fonctionnent avec la puce-système Apollo4 d’Ambiq fondée sur cœurs Arm Cortex-M4F fonctionnant jusqu’à 192 MHz pour les traitement des graphiques, de l’audio et des modèles d’IA. Ces lunettes qui ne pèsent que 37 grammes, procure jusqu’à 10 heures d’autonomie.

Vous pouvez aussi suivre nos actualités sur la vitrine LinkedIN de L'Embarqué consacrée aux microcontrôleurs : Embedded-MCU

Vous pouvez aussi suivre nos actualités sur la vitrine LinkedIN de L'Embarqué consacrée à l’intelligence artificielle dans l’embarqué : Embedded-IA